Epicが今年後半にリリース予定の忠実度の高いデジタルヒューマンを作成するための新しいツールを発表しました。ゲームのキャラクターメイクのような感じでリアルなデジタルヒューマンを短時間で作成できるようです。 作成したデータ […]

スゲー

「FINAL FANTASY VII REMAKE」メイキング

「FINAL FANTASY VII REMAKE」のメイキング記事が公開されています。 https://cgworld.jp/feature/202012-ffvll-01.html

Gullwing

メルセデスベンツ300SLガルウィングをフィーチャーしたcgショートフィルム。アニメーションも気持ちよくてライティングも綺麗、溢れ出る車好きを感じます。

“Shhhhh!!!” Animation re-make by Seng

アニメーションがいいですね。内容も面白い。

Brawl Stars - Barley’s Bar

手描きと3Dとドット絵が混ざってるのに統一感のある映像が面白い。

Making WebGL Dance

WebGLを使用したCGに使用される技術をまとめたプレゼン資料のようです。WebGLを使用したインタラクティブな内容がわかりやすくて面白いです。 http://acko.net/files/fullfrontal/ful […]

2Dイラストから3Dモデルを自動生成

2Dイラストから3Dモデルを自動生成する実験をしてる人を見かけました。面白いですね。 2Dイラストから3Dモデルを自動生成する実験の続きです。 目のランドマークを増やし、素体の変更を試してみました。今回は @YAN3dc […]

Tecmash

カッコイイ

VWLS - "High In Heaven"

ドローン200機を使用したミュージックビデオ。ドローンのアニメーションにCinema 4DとAR toolkit Moves by Maxonを使用してるらしいです。ドローンの移動をリアルタイムなリップシンクに見せるため […]

Vittel Biodiversité - Bee

絵の雰囲気がいいですね。

RETRO ARCADE ANIME: R-TYPE

R-TYPEを題材にしたレトロ風のアニメ作品。80年代へのこだわりが凄いです。 2Dアニメーションの3D背景トリック 80年代風のスペースシップをアニメーション化する方法

StyleGAN2を使用した高解像度画像の合成

機械学習を使用した高解像度のスタイライズド 画像生成だそうです。githubでソースが公開されてるようです。 https://news.developer.nvidia.com/synthesizing-high-res […]

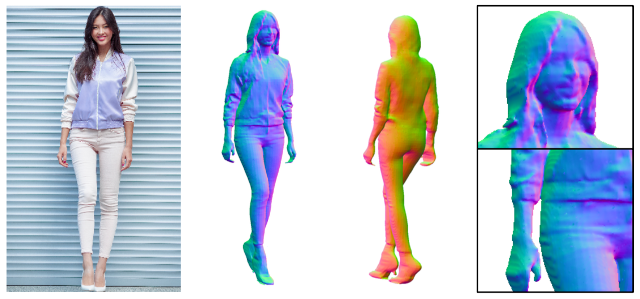

PIFuHD:高解像度3D人間のデジタル化のためのマルチレベルピクセルアライン暗黙関数

「PIFuHD」はディープラーニングを使用して、1枚の画像から高解像度の3Dモデルを生成する技術だそうです。 ディープラーニング形の画像生成は解像度が低い物が多かったですが、高解像度の画像を活用できるところが有望な感じし […]

The Mandalorian: Season 1 | Breakdown Reel | Image Engine VFX

The Choice TV Series | Visual Effects Breakdown

TVシリーズとのことだけどクオリティーが凄い。